-

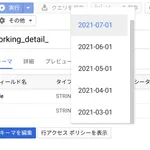

GA4のレポートデータをbigquery data transferで転送

リリース時点で一般公開(GA)機能。ga4コンソールにあるレポートテーブルの転送なので、基本の集計に限って言えばテーブル参照やクエリがやりやすくなっている

-

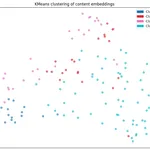

dbtでbigqueryのembeddingテーブルを作成する

ブログコンテンツのembedding作成しようと思ったが、記事の更新や作成に追従してembeddingも更新させたかったので、dbtにて管理することにした

-

github actionsで `Error: Cannot find module @rollup/rollup-linux-x64-gnu.` がでる

astroのビルドをgithub actionsで行うときにでてきたエラー

-

cloudflareでのシークレット環境変数の設定とastroからの参照方法

しばらくハマったのでメモ

-

svgを生成するmermaid cli actionsつくった

markdownファイルやmmdファイルのmermaid形式の記述をsvgファイルとして生成するactionsを作った

-

スプレッドシートをサービスアカウントから作成

サービスアカウントを用いて、スプレッドシートなど、google driveに存在するファイルの作成や操作をしたかった。その際、ユーザーからも閲覧や編集したい場合があるのでそのあたりの設定も行った

-

geminiでインフォグラフィックを生成してgoogle sitesで公開する

geminiのcanvas機能が気になったので使って見たメモ。インフォグラフィック(HTML)生成機能があったのでwebコンテンツとして公開するまでやってみた

-

Evidence Biのwebエディタ、Evidence Studio触ってみた

evidence bi構築用のwebエディタだしてたので触ってみた

-

対象サイトを検索するai agent with Agent2Agent (A2A)

AI agentの作成からA2Aのサーバー、クライアントをpythonで簡単に試す用のをつくったのでメモ

-

astro markdownのコードブロックのハイライトとmermaidのレンダリング設定

markdownのコードブロックと、mermaid構文のレンダリング設定

-

gitの認証切り替えるfor mac

gitで個人のprivateリポジトリのpullなどもできるようにしたかった

-

サイトの構築をastroに移行

このblogをastroで構築するようにした。いままで使っていたgatsbyjsは、remarkの作成やデータの加工に逐一graphqlで定義するのが少し面倒になったのと、buildがだんだん遅くなってきたので移行することにした

-

ローカルに作ったMCP serverをcopilot agentから使ってみる

自前でMCP serverを作成したかったが、使うまでの設定をどうやるのかわからなかったのでメモ

-

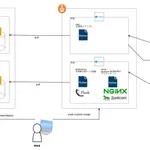

gcsのip filterを使って特定IPからのアクセスのみ許可する

GCSバケットへのアクセスに対してip制限を設定する機能ができたので試してみる。dbt docsのhtmlをホスティングして、アクセスしてみた。現状はpre-GAの機能

-

ブログにgeminiのgoogle検索groundingを使ったサイト内検索機能を作った

自然言語でサイト内検索機能を作りたかった

-

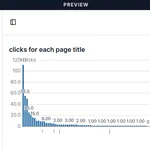

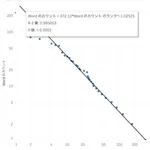

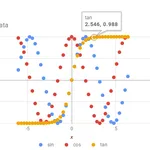

Evidence Biでブログダッシュボードを作った

このブログサイトに関する色々を可視化するダッシュボードをevidence biでつくったので、各種設定、コードなどのメモ

-

dlt(data load tool)でgithub上のファイルをbigqueryに転送する

ブログ記事のテキストデータとして色々分析や可視化をしたくなってきた。記事データはgithub上にmarkdownファイル形式でおいてあるので、それらを抽出し、bigqueryのテーブルとしてロードする。全体の流れとしてはprefectからdltにてデータロードを。データ加工はdbtな感じの流れにしている。この記事ではd...

-

mermaid cliで外部アイコンを使ったアーキテクチャ図を出力させてみた

[mermaid](https://mermaid.js.org/intro/)はwebベースで動くシステム図やグラフが描けるツール。github上でもレンダリングされるなど、使い勝手がいい。2024/9月あたりに[mermaidでアーキテクチャ図](https://mermaid.js.org/syntax/arch...

-

Evidence BIをvercelにデプロイする

# Evidence BIをvercelにデプロイする

-

ローカルでdagsterを使ってデータパイプラインの一連の処理を試した

ソースデータ取得から加工まで。一連を試すだけなので取得と変換はexample程度のものになっている

-

search console データをbigqueryに転送する

search consoleのデータもbigqueryへexportできるようになっていたので試した。2023/02から追加された機能だそう

-

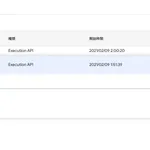

Google Cloud Workload Identity 連携を利用してdataform cliをGithub Actions上で動かす

Workload IdentityでApplication Default Credentials(ADC)できるらしいというのをみかけた。Github Actions上でdataform cliの実行(認証)ができるかどうかやってみた

-

streamlit・gradioでpdf ファイルを表示させる

streamli・gradioで、pdfファイルをアップロードして中身を表示させる方法を試してみた。どちらも案外かんたんにできた

-

bigquery の text embedding モデルでカテゴリ分類してみる

なにやらbigqueryのクエリからVertex AI テキスト エンベディングの基盤モデルを利用できるとのことで実験してみた

-

スタックチャン で CO2 センサー。Ambient で可視化

スタックチャン(m5stack basic)に CO2 センサーをつないで、数値を計測。[Ambient](https://ambidata.io/)(IoTデータの可視化サービス)に値を送信して、簡単に推移を可視化してみた

-

slack apps を作成してチャンネルへの投稿をコマンドラインから実行できるようにする

[slackcat](https://github.com/bcicen/slackcat) を使って time チャンネルにコメント投稿を行っていたが、あまりメンテナンスされていないようなので、slack apps を作成して、投稿できるようにしてみた

-

cube.jsでbigqueryのデータを集計してみる

cube.jsはheadless BIの一種。集計クエリを効率的に処理するためのオープンソースのデータ分析フレームワークであり、さまざまな集計条件について、APIで簡単に取得できる。ga4のbigquery exportデータについて適当に集計してみた

-

dbt cloud 触ったメモ

dbt 触ったメモ

-

dataform on GCP 実行環境構築

dataform を触ってみたのでメモ。基本的にローカルでの動作確認や github actions での CI なんかについてかいておく

-

ChatGPT with gradio

ローカルで ChatGPT API を使って動かす環境がほしかったので作ったメモ

-

immersedを使ってOculus Quest2バーチャルデスクトップ

Oculus Quest2 を買ったので、immersed というアプリを使って VR 空間上でリモート接続して PC 操作できるようにしてみたメモ

-

gatsbyjsのサイトをPWA対応する

やってみたかった。設定自体はpluginを入れるだけなので簡単

-

ga4にweb vitalsデータを送る

web-vitalsという各種指標を取得できるライブラリを見つけたのでgaに送信して眺められるようにしてみた

-

geopandasとpydeckで日本地図(都道府県)可視化

意外と大変だったのでメモ

-

gitpodで事前にpythonライブラリをインストールする

gitpod上のterminalでstreamlitなどを実行したかった

-

pdfから表データを取得してstreamlitで可視化。herokuにデプロイ

全国市販酒類調査という国税庁が毎年行っている、全国の酒類の品質や成分を報告データを可視化してみた。pdfファイルの最後の方に参考情報として載っている

-

clasp runで実行する時にパラメータ引数を指定する

表題の通り

-

GA4のbigquery exportデータをフラットにする

表題の通り

-

bigqueryのwildcard tableの作成、更新

wildcard tableはテーブル名に任意のsuffixをつけて作成することで

-

visx使って可視化

[visx](https://airbnb.io/visx)というairbnb発のreact用可視化ライブラリを触ったメモ

-

clasp導入

[clasp]([https://github.com/google/clasp](https://github.com/google/clasp))というgoogle製のapps script管理用cliを使ってみた

-

gatsbyカスタム作業メモ

やったことをかいておく

-

flutterで作ったアプリgithub pagesにデプロイ

`flutter web`を有効にしてみたので、github pagesで表示されるようにデプロイ方法を整えた

-

GCPの既存リソースをterraformerでimportする

GCPのリソース管理をterraformでやるために、まずは既存のものをimportしてみた

-

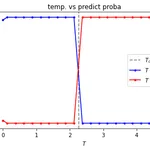

pythonでニューラルネットワークを使った相転移検出 - イジングモデルのシミュレーション、CNNで学習 -

"ディープラーニングと物理学"本にイジングモデルのシミュレーション結果を機械学習モデルの学習データとして用いて、

-

サイトの構成を更新した(hugo->gatsbyjs, netlify->vercel)時の作業メモ

サイト生成をhugoからgatsbyへ、ホスティングをnetlyfyからvercelにした

-

matrix factorizationの学習結果をtableauで可視化してみる

matrix factorizationを使用してmovie lensのデータから映画のレコメンドモデルを作成し、tableauで可視化してみる

-

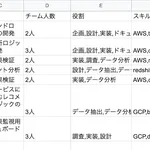

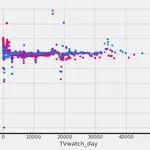

経歴のスキルセットと時間積み上げを可視化してみる

経歴書なんかを書くとき、プロジェクトの期間、スキルや役割を書いていくことが多い

-

qiita organization情報から組織とタグ(スキル)をみてみる

[qiita organizations](https://qiita.com/organizations)にあるデータをクローリングして人気のタグや規模の大きい組織をtableauで可視化した

-

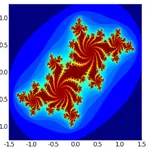

juliaでjulia集合のプロットとアニメーション

juliaでjulia集合を作成した。ついでにmandelbrot集合も。配列系の演算子(.など)の勉強になった

-

ブクログの本棚データを可視化

[ブクログ - web本棚サービス](https://booklog.jp)

-

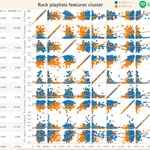

spotify apiでrock playlist楽曲の特徴を取得して可視化

spotifyのapiを使ってデータを取得してみた。

-

aws sagemakerでカスタムモデルをつかう

sagemaker上で独自の学習モデルや予測結果を取得したいとき、

-

aws chaliceでlambda関数の作成

[chalice](https://github.com/aws/chalice)はAWSの公式ツール。api gatewayとlambdaを

-

cloud composer(airflow)でbigqueryテーブルの集計結果をGCSへupload

bigqueryの集計結果をGCSに出力したかった。しかし、どうやら1回でできそうなoperatorがなかったため、結果を一旦集計テーブルとして作成し、GCSにexportする形をとった

-

tensorflowで作成したtfliteモデルをflutterで利用する

モバイルにある画像orカメラで撮った画像に対して画像分類するアプリを作った。android端末で試した

-

tensorflowで美術作品の画像データから芸術様式を予測するモデルの作成

tensorflowで画像分類モデル(VGG19)を用いて絵画の画像データから芸術様式(写実主義、シュルレアリスム、印象派など)を予測するモデルをつくった

-

material uiのiconがfirefoxでレンダリングされない

firefoxのブラウザ設定をいじる必要がある、つまりクライアント側の問題となる模様

-

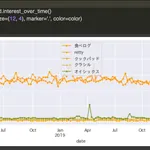

pytrendsでgoogle trendのデータを取得してみる

pytrendsを試しがてら、食に関するサービスについてトレンドを比較してみた

-

論文メモ:多様性の導入による推薦システムにおけるユーザ体験向上の試み

[多様性の導入による推薦システムにおけるユーザ体験向上の試み](https://www.jstage.jst.go.jp/article/jnlp/24/1/24_95/_pdf)

-

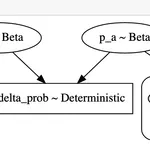

pymc3を用いてベイズ統計によるABテスト結果検証用notebookを作った

いわゆるベイジアンABテスト。流行ってそうなので、挑戦してみた。

-

論文メモ: Access Patterns in Web Log Data: A Review

[Access Patterns in Web Log Data: A Review](http://his02.softcomputing.net/jnic4.pdf)

-

docker上のjupyterlabでtensorboardの表示

docker上でやると多少コマンドやオプション等が異なったので残しておく

-

causalmlのT-learnerでATEを算出

[causalml](https://github.com/uber/causalml)を試した。岩波データサイエンス vol.3に載っていたデータを使って、平均処置効果とアウトカムの推定に用いた特徴量のimportance等を出してみた

-

poetryでpython packageをgithub urlで公開

[poetry](https://github.com/python-poetry/poetry)は、パッケージマネージメントや、パッケージ作成を簡単にしてくれるツール

-

implicitでレコメンドを試す

python implicitで暗黙的フィードバックデータからレコメンドモデルを作成した

-

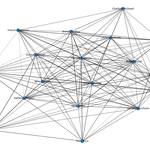

networkxで2部グラフ解析 - スペクトラルクラスタリング -

[networkx](https://networkx.github.io/documentation/stable/index.html)を使って、2部グラフのネットワーク解析

-

pythonとtableauでscotch whiskyの味の特徴を分析、可視化

pythonでデータを作成し、tableauにて可視化を行った

-

google colaboratoryからspreadsheetsへdataframeの読み書き

google colaboratoryからgoogle spreadsheetsにdataframeを読み書きする方法

-

ginzaとnetworkxで共起語ネットワーク作成

[ginza](https://github.com/megagonlabs/ginza)と[networkx](https://github.com/networkx/networkx)を用いて共起語ネットワークを描画する関数を作った。せっかくなので残しておく

-

aws sagemaker notebook instanceでpapermillを使う

[papermill](https://github.com/nteract/papermill)は、jupyter notebookファイルをcliやpythonから実行できるようにするツール

-

BrainPad SQLForBeginners2019をbigqueryでやってみた

brain padの新卒研修で行われているらしいデータ集計のための教材[GitHub - BrainPad/SQLForBeginners2019](https://github.com/BrainPad/SQLForBeginners2019)をgoogle bigqueryでやってみた

-

aws Amazon API Gatewayでcloudwatchログを有効にする

Amazon API Gatewayのリクエストログ等をcloudwatchで見られるようにする

-

networkxで2部グラフ解析 - 可視化 -

[networkx](https://networkx.github.io/documentation/stable/index.html)を使って、2部グラフのネットワーク解析をしてみたい

-

論文メモ: ネットワーク構造を対象とした特徴量抽出とその応用

論文メモ:

-

uplift model - 概要 -

upliftについて、考え方とアプローチ方法をまとめておく

-

causalmlを試す。uplift classification

[causalml](https://github.com/uber/causalml)はuberによる機械学習を用いた因果推論用のpythonパッケージ。例が載ってるノートブックを使って、一連の流れを試してみた

-

surpriseでレコメンドを試す

[surprise](http://surpriselib.com/)はレコメンドアルゴリズムをscikit風のインターフェイス使用できる、pythonパッケージ。予測結果の取得もいい感じにできる

-

dockerでgpuコンテナの作成

docker19.03にて、dockerコマンドでgpuコンテナを作成できるようになったとしり、試した

-

ubuntuにflutterインストール、android端末で起動

flutterはgoogleがつくったモバイルアプリの開発フレームワーク。iOS、Android用のアプリが作成できる。開発にはdartという言語を用いる

-

xgboostモデルのセーブ、ロード

使い方知らないとうまくできなかったのでまとめておく

-

アトミックデザインとは

atomic designについて読んで、考えていく

-

bootstrap法

bootstrap法について、考え方と、使い方をまとめておく

-

機械学習を用いたA/Bテスト - チュートリアル -

こちらの記事

-

Google Kubernetes Engineチュートリアル locustを動かす

google公式チュートリアルを試してみた

-

kubeflowをdocker-for-macにインストール

kubeflowはgoogleが作った機械学習パイプラインを作成するためのフレームワーク。macで試した。

-

google colaboratoryでcloud ML APIsを使う

cloud ML APIsは`Cloud Natural Language API`や`Cloud Speech-to-Text`

-

t-sneとは

t-sne について、理論とか知りたくなったので調べてまとめてみる

-

hugoで作ったblogにalgoliaで全文検索機能を追加する

作ったページのコンテンツに対して検索をかける機能がほしかったので、algoliaのフリープランを使って全文検索できるページを追加した

-

When 完璧なタイミングを科学する

感想

-

ヒューム読本

感想

-

ロシア絵画の至宝展 - 2018/10/7~12/24

行ってきたメモ

-

kubernetesでmicro-service(React, Flask, PostgreSQL)のローカル開発環境を構築

kubernetes を使ってローカルで web アプリを開発できる環境を整えてみた

-

Haskell勉強メモ1

haskellの概要や用語の説明をまとめておく

-

iHaskellのインストールと実行

haskellの実行環境をjupyter notebook上で整える。iHaskellというらしい

-

Haskell勉強メモ2 -stackで開発用環境構築-

stackというツールでhaskellのプロジェクト管理をしてみる

-

CDNとは

CDN(Content Delivery Network)についてまとめておく

-

中動態の世界

感想

-

このブログの開発環境と設定

このブログの開発、デプロイ環境をメモしておく。なるべく無料なサービスで構築した

-

kaldiで英語の音声認識テストまで

kaldiという音声処理のOSSを試した

-

gcloudコマンドでGoogle Speech APIを使って再生時間の長い音声の文字起こしを行う

Cloud Speech APIを使って1時間くらいの長さの音声ファイルを

-

pythonでgoogle map apiを使って緯度経度から住所を取得

google geocoding apiをつかって

-

react、firebaseでブラウザからcloud storageに音声ファイルアップロード

reactで作ったweb画面から音声ファイルをブラウザへアップロード

-

vue.jsでelement uiの使用言語を切り替える

vueでelement uiを使っているときに起きたことを書いておく

-

強化学習フレームワークgoogle dopamineインストール、テストまで

dopamineとはgoogleが開発したtensorflowベースの強化学習のフレームワークのこと

-

tensorflowjsのpre-trained modelを実行してみる

tensorflowjsには学習済みのモデルがいくつか公開されている。その中のmobilenetについてreactでデモページを作って試してみた

-

google compute engine(gce)のディスクの容量を増やす方法

gceを使ってるとインスタンスの容量が足りなくなることもある

-

google colaboratoryで引数を指定して.pyファイルを実行

google colaboratoryで.pyファイルに引数を指定して実行したかったのでやってみた

-

React Google Chartsで散布図

React Google Chartsはその名の通り、google chartのreact component版

-

docker上のjenkinsでdockerを実行

docker内のjenkinsでdockerコマンドを実行するための設定方法を書いておく

-

Makefile使い方メモ

Makefileを使うと長いscriptを保存して、簡単なコマンドで使えるようになる

-

golangのprivateリポジトリをdepで管理

githubのprivateなリポジトリをdepで管理してみる

-

dockerでhadoopクラスター作成

hadoopクラスターを触ってみたくてdockerで構築してみた。クラスター自体はambariを使って構築した

-

kaggle-api kaggleコマンドの使い方

kaggle公式のcliツール。kaggleのコンペについて調べたり、データセットのダウンロード、予測結果を送信したりできる

-

google Colaboratoryでファイルを読み込む方法

[Google Colaboratory](https://colab.research.google.com/)とはgoogleが作った

-

nvidia-dockerでGPUコンテナの作成

nvidia-dockerはdockerコンテナ内でnvidia gpuを使うためのOSSのこと

-

dep(golang)のGopkg.lock内のバージョン情報を変更する

[dep](https://github.com/golang/dep)とは、golangのpackageをローカルで管理するためのツール

-

docker swarmでOpenFaaSしてみる

docker swarmでOpenFaaSを起動するまでやってみた

-

Docker for MacでKubernetes インストールからデプロイまで

kubernetesを内蔵したDocker for Macがリリースされたらしいので、試してみた

-

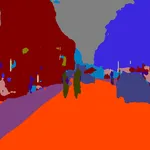

keras(tensorflow)でSegNet

SegNetは、ケンブリッジ大学が開発した画素単位でのラベリング機能を実現する、A Deep Convolutional Encoder-Decoder Architectureのこと

-

kerasでtensorboardの表示とmodelの保存

## 環境

-

jsonファイルをinfluxdbのfieldsに保存する

1行ごとに値の入ったjsonファイルをinfluxdbのfieldsに保存するプログラムを書いた

-

Docker for Macのvolumesの場所

docker-composeにてvolumesを指定すると、dockerコンテナを再起動してもデータが消えないようになる

-

dockerコンテナのlogをAmazon CloudWatch Logsに保存する

EC2上で動いているdockerコンテナのログを

-

docker-composeでPHP7+composer+MySQL環境の構築

docker-composeでphpの開発環境を構築する

-

docker swarmクラスタを複数ホストで作成、docker imageをbuildしてデプロイ

docker swarmはコンテナのクラスタを作成できる。また複数ホストにまたがってクラスタを構築で

-

同一端末で異なるgithubアカウントにpushするときの手順

個人用、会社用などでgithubアカウントが複数あり、

-

kopsを使ってaws上に構築したkubernetesクラスタにaddon(dashboard系)を追加する

kopsを使ってaws上に構築したkubernetesクラスタへkubernetes dashboard、weave scopeを追加する

-

awsでkubernetes環境構築〜kopsでクラスタ作成〜

aws上にkubernetesの環境を構築する。クラスタ作成(masterとnodeの構築)まで書いていく

-

kubernetesでAWS ecrのdocker imageを使ってコンテナ作成

privateなdockerレジストリからdocker image pullする時に困ったので手順を書き残しておく

-

デフォルトでpython3系を使っているとnodeのインストールに失敗する

### 環境